El martes pasado iniciamos el teórico (Lado B) con esta corta presentación. Era una funda un poco pobre (al estilo Altered Carbon) de una pila mucho mas rica, a continuación la desovillamos.

1 Cuando solo se habla de la Inteligencia Artifical, es porque no se está hablando de muchas otras cosas mas

Una cátedra que carga en sus mochilas mas de 20 años de estar revoloteando acerca de un conjunto de temas que en sus orígenes eran esotéricos y no muy sexies (Inteligencia artificial, algoritmos, web, la nube), y que de pronto se ve desbordada porque sus extravagancias y especulaciones se han convertido en lugares comunes, tiene sus propios problemas de identidad.

Venimos lidiando con la inteligencia artificial, las plataformas sociales y los algoritmos desde hace casi 20, 10 y 5 años respectivamente. Lidiando, es decir enredándonos voluntariamente en una trama de exégesis, cuestionamientos, dudas y abrazos intermitentes, en donde un día las redes son la meta-innovación mas maravillosa de la humanidad, y la siguiente se trata de astucias de la razón capitalista para maximizar la ganancia de unos pocos -demasiado pocos- en detrimento del resto.

Durante años descubríamos papers supertécnicos y nos atorábamos con las propuestas contradictorias y mutuamente excluyentes del paradigma sintético y del programa conexionista en IA, sin mayores consecuencias. Nuestro ocio no era el negocio de casi nadie. Así cualquiera. Los técnicos nos tildaban de diletantes, los humanistas de reduccionistas.

En el ínterin hemos ido y vuelto mil veces. Hemos refinado nuestras distinciones, nos hemos sumado a las huestes de críticos/hacedores de todo tipo con capacidades notables de diseño y de diagnóstico. Convirtiendo a este pandemónium en un espacio hiperbólico nutrido de potentes categorías, de herramientas de visualización inexistentes hace pocos años, y sobretodo de un feliz maridaje entre las abstracciones políticas y las manipulaciones materiales.

Cuando comenzamos nuestros desvaríos teóricos en la cátedra hace ya casi un cuarto de siglo nos tildaban de los locos de la web. Hoy de apocalípticos nos habríamos convertidos en integrados, de críticos en apologistas, de curiosos en meros usuarios.

Sobre nuestras obsesiones, igual que sobre nuestros objetos de estudio es posible hacer N lecturas posibles. Pero hay una diferencia clave entre entonces y ahora. Allá lejos y hace tiempo hablábamos de especulaciones, de futuros posibles (no sabemos si deseables). Estábamos mas cerca de la ciencia-ficción que de la ingeniería.

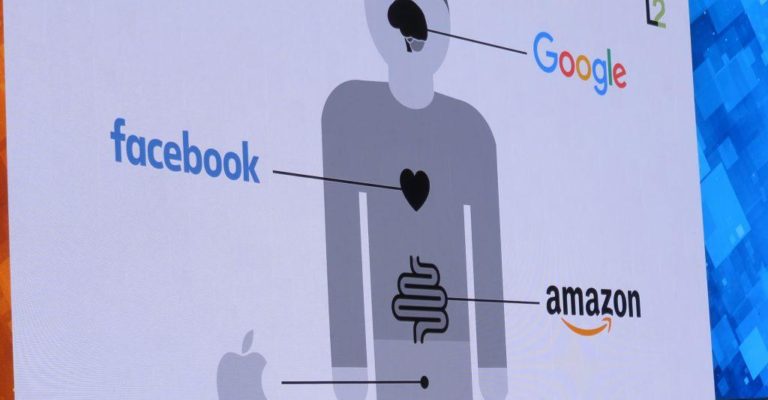

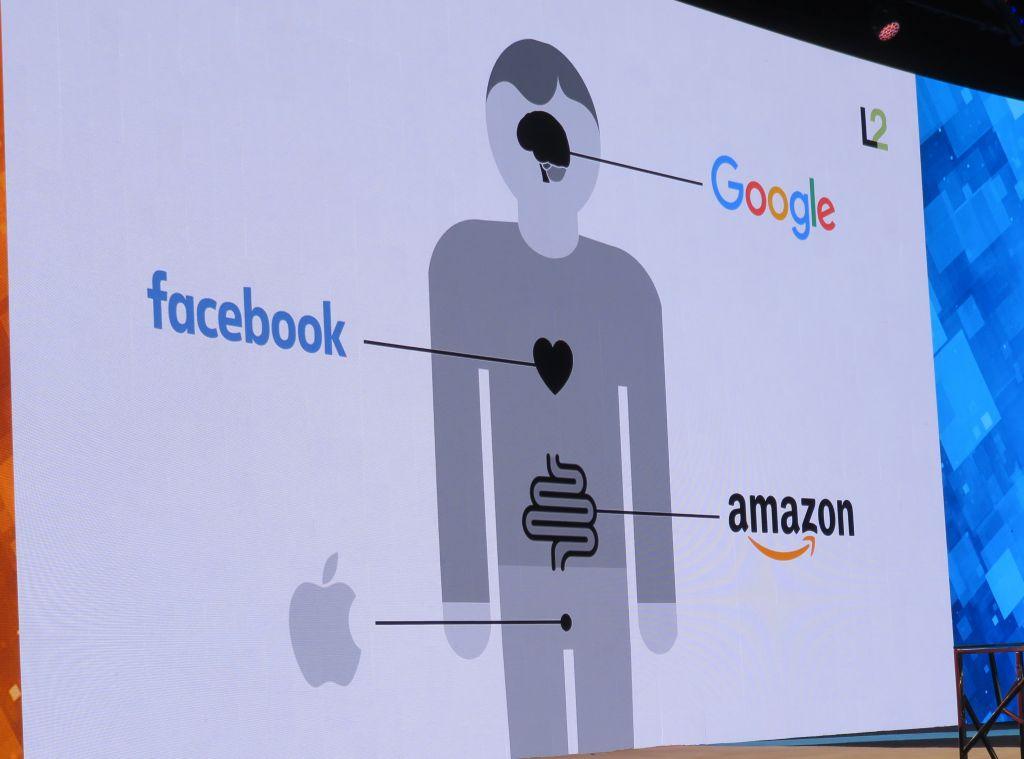

Con el advenimiento de las startups (hoy peces baratos que las empresas GAFAS se comen de un santiamén a borbotones), de las plataformas sociales, de monstruos tecnológicos como Apple y Amazon, nuestras discusiones han cambiado totalmente de nivel y valor.

Lo que criticábamos rápido y altisonantemente debe ser tamizado por lecturas antropológicas, sociotécnicas y en el marco de la complejidad, mucho mas sutiles que la hojarasca ideológica que reconocemos desde siempre.

Pero ni siquiera los comentarios mucho mas lúcidos de un Evgeny Morazev, o un Byung-Chul Han pueden penetrar mucho en el control de la subjetividad logrado por las GAFA.

Mientras, nosotros retomamos los primeros escarceos con la Inteligencia Artificial, pero ahora a partir de su “democratización” y penetración de todos los poros de la vida social. Lo que antes era un fantasma en la máquina es ahora la máquina de todos los fantasmas y la posibilidad de que las IA´s se conviertan en nuevas personas no-humanas (como lo son ahora los animales) plantea maravillosos interrogantes acerca de qué son y quiénes como nosotros.

En este contexto el teórico 3 Lado B abordó algunas de estas cuestiones y las vuelve a someter a su consideración. .

Ahora profundizaremos un poco mas lo que está en juego en estas promesas de la singularidad, y qué aspectos nos parecen mas interesantes (y cuáles mas dañinos) en esta danza sin fin en la coevolución de los humanos con las máquinas.

2. Tecnofílicos y tecnofóbicos como siempre

Esta tensión (el hipotético advenimiento de inteligencias mas que humanas) puede ser la madre de todos los problemas, pero encararlo de un modo ingenuo (a favor o en contra al mejor estilo grieta), nos deja en una posición inerme e ingenua. Por ello avanzaremos en distintas direcciones que van mucho mas allá de cierto extremismo de los defensores de la Singularidad, sin por ello descuidar sus propuestas, u tambièn en la de sus críticos.

¿Si la singularidad ocurriera será para bien o para mal?

Según una linea de tecnofilicos con Ray Kurzweil a la cabeza, seria decididamente para bien

Este apostol del transhumanismo, ingeniero experto en inteligencia artificial, cree que estamos acercándonos al momento en que las máquinas se vuelvan conscientes. A ese momento él lo llama, la singularidad.

Es un hecho que los ordenadores son cada vez más rápidos, y también es un hecho que esta aceleración en su potencia de cálculo sucede cada vez más rápidamente. A ese ritmo increiblemente rápido, es lógico pensar que llegará un momento en que sean capaces de hacer algo que imaginamos exclusivamente al alcance de la inteligencia humana.

No nos rewferimos a hacer aritmética a un ritmo endiablado, o a componer música de piano, sino a conducir coches, escribir libros, tomar decisiones éticas, apreciar la belleza de las obras de arte, hacer observaciones agudas durante un cóctel.

Cuesta hacerse a la idea, pero Kurzweil y otros muchos humanos inteligentes, creen que esto va a suceder. Cuando se alcance ese punto, no hay razón para creer que las computadoras detendrán el proceso para dejar de hacerse más y más poderosas -como anuncia la ciencia-ficciñon apocalíptica.

De hecho, no cesarían hasta hacerse mucho, mucho más inteligentes que nosotros. El ritmo de avance seguiría acelerándose, ya que serían ellas quienes apartarían a sus creadores humanos (tan lentos a la hora de pensar) para tomar las decisiones que afectarían a su propio desarrollo (al mejor estilo Skynet en Terminator).

Kurzweill lo enuncia de manera menos dramátics pero mas convincente

El poder acelerador de la tecnología

O como lo expresa aquì Olvídate de hoy y ve haciendo planes para 2099.

En el otro extremo de la pantalla estimados alumnos están varios pesos pesados entre ellos Nick Bostrom.

La inteligencia artificial se está volviendo más inteligente a pasos agigantados: dentro de este siglo, sugieren numerosas investigaciones, las IA podría ser tan «inteligentes” como un ser humano. Para luego, dice Nick Bostrom (1973- ), alcanzarnos (¿o superarnos?)

Bostrom es un filósofo sueco de la Universidad de Oxford conocido por su trabajo sobre el riesgo existencial, el principio antrópico, la ética del mejoramiento humano, los riesgos de las superinteligencia y la prueba de reversión. En 2011, fundó el Programa Oxford Martin sobre los Impactos de la Tecnología del Futuro, y actualmente es el director fundador del Future of Humanity Institute en la Universidad de Oxford.

«La inteligencia artificial es el último invento que la humanidad necesitará hacer alguna vez».

Como filósofo y tecnólogo, Bostrom nos pide que pensemos en el mundo que estamos construyendo en este momento, impulsados por máquinas pensantes. ¿Nuestras máquinas inteligentes ayudarán a preservar la humanidad y nuestros valores, o tendrán valores propios?

Nick Bostrom What happens when our computers get smarter than we are?

3. ¿Porqué no conviene creer en inteligencias naturalmente benignas?

La inteligencia humana es muy poderosa. Un minúsculo aumento en la capacidad de resolver problemas y la coordinación en grupo nos bastó para dejar al resto de simios en la estacada. Ahora nuestra supervivencia depende de las decisiones humanas, no de sus actos. La inteligencia es una auténtica ventaja para personas y organizaciones, por lo que se invierte un esfuerzo enorme en idear formas de mejorar nuestra inteligencia individual y colectiva: desde los fármacos que potencian el conocimiento hasta los programas de inteligencia artificial.

No hay motivos para pensar que la inteligencia por sí misma haga que algo se comporte con bondad y ética. De hecho, se puede demostrar que determinados tipos de sistemas superinteligentes no obedecerían las leyes éticas aun cuando fuesen correctas (vioolando asi las expectativas de Las leyes roboticas de Asimov (Runaround/Círculo Vicioso (1942))

1. Un robot no hará daño a un ser humano o, por inacción, permitir que un ser humano sufra daño.

2. Un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entrasen en conflicto con la 1ª Ley.

3. Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la 1ª o la 2ª Ley.1.

Lo que resulta más preocupante todavía es que al intentar explicar algo a una inteligencia artificial tropezamos con profundos problemas prácticos y filosóficos. Los valores humanos son elementos difusos y complejos, que no se nos da bien expresar; además, aunque seamos capaces de hacerlo, puede que no entendamos todas sus consecuencias.

Algo que fue retomado en clave de divulgación por Facundo Manes en estos días en ¿Pueden las máquinas llegar a ser más sabias que los humanos?

La inteligencia informática podría pasar rapidísimamente de estar por debajo de la humana a tener un poder terrorífico. Se ha insinuado que podría producirse una “explosión de la inteligencia” cuando los programas se vuelvan lo bastante sofisticados como para diseñar mejores programas. Si se produjera un salto semejante, habría una gran diferencia de poder potencial entre el sistema inteligente (o las personas que le dicen cómo actuar) y el resto del mundo. Está claro el potencial para el desastre si los objetivos establecidos no son los idóneos.

Hay motivos de sobra para pensar que algunos tipos de tecnología podrían hacer que las cosas se acelerasen a una velocidad mayor de la que la sociedad actual (y la futura) es capaz de asimilar. Es más, tampoco tenemos claro lo peligrosos que podrían ser las diferentes tipos de superinteligencia, o qué estrategias de mitigación funcionarían.

Resulta muy difícil teorizar sobre una tecnología futura de la que aún no disponemos, o sobre una inteligencia mayor que la nuestra. De los riesgos de esta lista, este es el que más probabilidades tiene de ser, o bien catastrófico, o bien un mero espejismo.

Sorprendentemente, este es un ámbito muy poco investigado. Ya en las décadas de 1950 y 1960, cuando la gente estaba convencida de que la superinteligencia podía alcanzarse “en una generación”, no se prestaba demasiada atención a las cuestiones de seguridad, hoy han dado lugar a una profusa literatura que se explora a continuaciónn .

4. ¿Cómo adentrarnos mas y mejor en el tema?

El investigador Anders Sandberg analiza los mayores riesgos para el ser humano en Los cinco jinetes del apocalipsis. Allí junto a la 1. Guerra nuclear; una 2. Pandemia provocada por la bioingeniería, la 3. Nanotecnología y 4. Riesgos desconocidos que aún no conocemos y la ubica a la 5 In teligencia artificial en una igualdad de plano con las cuatro anteriores.

Lo mismo ocurre en «El futuro de la humanidad en sus manos Un equipo de expertos investiga en un Instituto de Oxford los riesgos de extinción del ser humano»

Y también aquí Hugo de Garis, y su visión de la guerra entre terrestres y foraneos The artilect war

Exposiciones recientes han tocado en detalle estas preocupaciones

EXPO +HUMANOS El futuro de nuestra especie 7 octubre 2015 – 10 abril 2016

Ciborgs, superhumanos y clones. ¿Evolución o extinción? ¿Qué significa ser humano hoy? ¿Cómo será la humanidad dentro de cien años? El potencial tecnológico avanza con gran rapidez; ¿debemos seguir modificando nuestro cuerpo, nuestra mente y nuestra vida cotidiana, o hay unos límites que no podemos rebasar?

Cathrine Kramer es su comisaria ejecutiva y ha contado con la colaboración del investigador Ricard Solé

Y la filósofa Rosi Braidotti Lo post-humano ha ahondado tambièn en la cuestión en un reciente libro.

Braidotti una feminista italoaustraliana (1954) declarada heredera de la tradición de Spinoza, aboga por trascender la negatividad construyendo, desde ya, futuros posibles. Y afirma que las nuevas tecnologías, bien usadas, son una poderosa herramienta de cambio hacia un futuro posthumano que permita corregir muchas de las cosas que hizo mal el humano a secas.

En los últimos 20 años, entre las dietas, el fitness, el bótox, la cirugía estética y la implantación de pelo, ya ha habido un cambio evolutivo, todo el mundo tiene buen aspecto. Y como estamos más sanos y somos más ricos, vivimos más. Pero no estamos en un solo camino hacia la gloriosa evolución; es una vía que hace zigzag”

En el próximo teórico continuaremos esta exploración revisando cuales pueden ser sus implicancias para el trabajo humano y la definición de lo que nos hace humano (si no es el trabajo significativo, que si lo es?

Comentarios