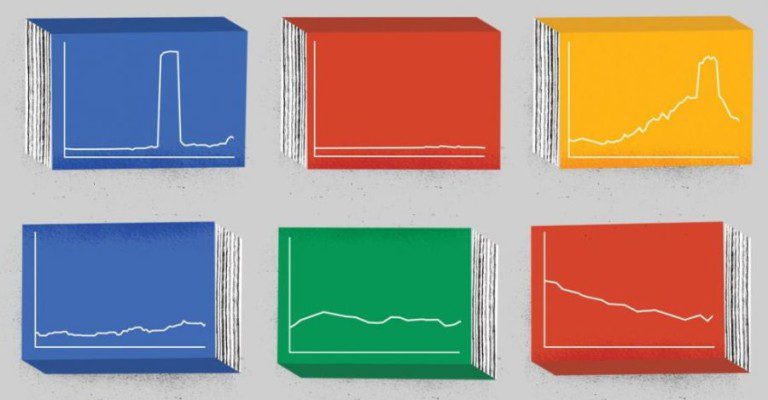

Allá lejos y hace tiempo nos poníamos en contacto con Google Ngram Viewer

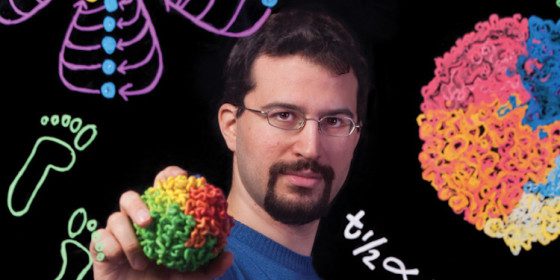

Hace un año atrás nos desayunábamos de la existencia de una poderosa herramienta de análisis cultural (aunque disfrazada de análisis lingüístico) titulada Google Ngram Viewer. Partiendo de un sinóptico paper lleno de perlas, intuiciones y preguntas fantásticas como fue Google Quantitative Analysis of Culture Using Millions of Digitized Books, una decena de autores entre los que se encontraban Jean-Baptiste Michel y Erez Lieberman Aiden pateaban el tablero y sumaban muchos puntos a la neonata máquina de hacer preguntas propia de las Humanidades Digitales.

De la mano del fantástico proceso de digitalización de la historia humana hecho por Google (contando ya con 30 millones de los 130 millones de libros que se publicaron desde tiempo inmemorial en todos los idiomas conocidos y también los desaparecidos), los autores prometían una nueva forma de investigar, de ampliar el horizonte de la reflexión, de introducir anclajes cuantitativos en el mundo de las ciencias sociales, demasiado atravesado por la retórica y la ideología, pero sobretodo de sumergirse en corpus masivos de datos inexplorados (e inexplorables bajo la temporalidad humana, la capacidad analítica y las morosas estrategias de la exégesis), aplicables a la lectura cercana pero totalmente ineficaces cuando del big data y la lectura dintante se trata en constante expansión.

No es la menor de las paradojas (y mas que agradable en este caso) que el análisis cuantitativo de millones de libros haya generado un nuevo libro (al que seguramente se lo someterá al mismo análisis que él hace sobre los demás) como es Uncharted. Big Data as a lens of human culture de Jean-Baptiste Michel y Erez Lieberman Aiden< en el cual se retraza con deliciosos detalles el recorrido hecho por los autores desde los inicios del diseño de la herramienta hasta sus aplicaciones mas variadas y estimulantes un lustro mas tarde.

De las cuentas a los cuentos

En varios oportunidades en la catedra de Datos nos topamos con los orígenes de la escritura. Gracias a los trabajos señeros de Denise Schmandt-Besserat como How writing came about (1992), sabemos que hace 10.000 años atrás los pastores inventaron las inscripciones sobre piedra como forma original de notación y conteo. Alrededor del 4to milenio antes de Cristo alguien decidió que mejor que atesorar muchas piedras diferentes pequeñas era mas económico hacer muescas de distinto grosor y contenido en una piedra grande, así nació la escritura. Mucho antes de que tuviéramos la escritura de los profetas tuvimos la de las ganancias (prophets/profits).

Si la innovación siempre estuvo ligada a los negocios (antes que al ocio) ello hoy es mas contundente que nunca. Pero los jinetes del apocalipsis como Google, Facebook, y Amazon no crean registros simplemente como un subproducto para hacer negocios. Lo propio de estas compañías «expresivas» es crear herramientas (plataformas) que permiten que sus usuarios se representen a si mismos e interactúen entre si en la red. Y lo hacen generando huellas digitales que acompañan parí passu el despliegue de la vida en línea. Para estas compañías el registro de la cultura humana es su core business (aunque muchos no se den cuenta, ni acepten que la antropología digital -rama señera de las Humanidades Digitales- es una lente de observación de la cultura de un poder inusual).

El registro es permanente, invisible y resume todos nuestras recomendaciones, nuestros «me gusta«, nuestro browseo de libros en Amazon, o el paseo por cualquier tienda de artículos aun cuando casi nunca compremos nada. Aunque nos hayamos olvidado de la puteada que le mandamos a alguien en un mail, de la borrachera que alguien tuvo la gentileza de etiquetar en Facebook… Si escribimos un libro Google lo escanea. si sacamos una foto Flickr las archiva, incansablemente. Cada película que hacemos está presta a ser stremeada en Youtube. Todos somos hoy Hansel y Gretel digitales que dejamos migajas digitales que herramientas como Ngram, Manyeyes, Last.forwardFidgt, DiggTools, … convierten en sentido.

Estamos hablando de cantidades gigantescas de datos, por eso antes de dar algunos ejemplos de la inesperada combinación mágica cuando los datos se encuentran con intérpretes dignos de su magnitud, hagamos un relevamiento rápido de la cantidad de datos que generamos a diario, cifra que ha aumentado exponencialmente desde los estudios llamativos hechos por la School of Information de Berkeley en 2003, que los situaban en la tímida cifra (en esa época no menos llamativa) de los 3 exabytes anuales.

El corrimiento hacia el rojo de la producción de información

Así como el universo está (para sorpresa del propio Albert Einstein) en irrefrenable expansión, la producción de información durante los últimos siglos, décadas y años también está en un estado de explosión permanente. Actualmente la producción anual per capita de información alcanza a un terabyte, (es decir al equivalente de ocho billones de preguntas si/no). Como colectivo eso significa que la humanidad produce 5 zetabytes de datos anuales o sea 40,000,000,000,000,000,000,000 (40.000 trillones de bits anuales) (Ver John Gantz and David Reinsel, «The Digital Universe in 2020,» EMC Corporation, December 2012 y «Data, Data EverywhereEconomist, February 25, 2010).

Se trata de números tan gigantescos que resulta prácticamente imposibles representarlos aunque podemos convertirlos en 0 y 1 escritos a mano y tratar. En ese caso 1 megabyte consistiría en una linea de 1s y 0s 5 veces mas alta que el Everest, un exabyte llegaría al centro de la Via Láctea, y si los cinco zetabytes se usaran para contar ovejas, estaríamos hablando de una invasión totalitaria de ovejas que ocuparían todo el espacio del universo sin dejar ningún lugar vacío

Si no sabíamos muy bien a que se refería el Big Data aquí queda mas que bien ejemplificado. Pero lo mas fantástico es que nuestra huella digital se duplica cada 2 años gracias a las mejoras en el almacenamiento, aumento de la velocidad del ancho de banda, y sobretodo a nuestra migración como res extensa al mundo del ciberespacio.

Los pioneros del Big Data

Ahora que cualquiera puede usar Ngram volvemos s sufrir el espejismos de la naturalización. Nos parece obvio que un robot genere brillantes hipótesis y que cada día estemos minando la historia obteniendo resultados sugerentes e inesperados. Después de todo en el paper pionero de Jean-Baptiste Michel y Erez Lieberman Aiden et al, citado mas arriba quedaba claro que Ngram era una herramienta mas que útil para el análisis de partituras musicales, la evolución de la gramática, la memoria colectiva, la adopción de tecnología, la búsqueda de fama, la censura y la epidemiología histórica. Pero antes de entreverarnos con su potencia heurística, en los resultados que ha venido burilando y en las inmensas promesas que tiene para la consolidación de las Humanidades Digitales (todo lo cual esta sagazmente encapsulado en el primer libro Uncharted: Big Data as a Lens on Human Culture de Michel & Aiden que acaba de ser publicado) revisemos algunos antecedentes llamativos de análisis de Big Dato que merecen una consideración detallada.

Jon Levin (ver Liran Einav et al., «Learning from Seller Experiments in Online Markets,» National Bureau of Economic Research (September 2011) un economista de Stanford ,trabajó estrechamente junto eBay para examinar como se establecen precios en los mercados en tiempo real. Levin aprovechó que los vendedores de eBay llevan adelante microexperimentos para decidir que precio ponerle a sus ventas. Estudiando centenares de miles de esos experimentos en simultáneo, Levin pudo verificar algunas hipótesis acerca de la teoría de los precios pero también cuestionar varios de sus supuestos nunca previamente testeados, que equivocadamente se tomaban por ciertos. De paso ganó la Medalla John Bates Clark, un premio que se otorga a los investigadores sub-40, y que muchas veces anticipa su postulación para el Nobel

Por su parte un equipo de investigaciones de la Universidad de California en San Diego dirigido por James Fowler (autor del celebre…Connected: The Surprising Power of Our Social Networks and How They Shape Our Lives -How Your Friends’ Friends’ Friends Affect Everything You Feel, Think, and Do con Nicholas Christakis) se uníó a Facebook para hacer un experimento sobre 61 millones de sus miembros (Ver Robert M. Bond et al., «A 61-Million-Person Experiment in Social Influence and Political Mobilization,» Nature 489, no. 7415 (2012): 295-98). El experimento mostró que un «amigo» tenía muchas mas posibilidades de registrarse como votante después de anoticiarse de que otro amigo se había registrado previamente. Cuanto mas cercano el amigo mas fuerte era la propensión a registrarse. Mas allá de la sorpresa de que Facebook puede ser un catalizador «efectivo» de la participación política (algo que examinamos alla lejos en el proyecto Facebook en el 2009 en Buenos Aires), lo cierto es que en este caso puntual fueron 300.000 los nuevos votantes contagiados por sus amigos, una cifra tan importante como para dar vuelta una elección

Mientras, nuestro conocido Albert-László Barabási, un físico de la Universidad de Northeastern en Chicago (autor del celebre Linked. How Everything Is Connected to Everything Else and What It Means for Business, Science, and Everyday Life) trabajó con varias compañías telefónicas enormes tratando de identificar los movimientos de millones de personas estudiando la huella digital dejada por los teléfonos celulares (ver Chaoming Song et al., «Limits of Predictability in Human Mobility,» Science 327, no. 5968 (2010): 1018-21). El resultado obtenido fue un gigantesco dendograma del movimiento humano a escala de las ciudades en su conjunto. Fue tan bueno el análisis que en muchos casos era posible predecir los estados futuros de las personas (donde se encontrarían en el momento n + 1), en particular gracias a la potencia de los modelos matemáticos obtenidos.

Mas y mejores ejemplos

Como ya lo habían anticipado en el paper seminal sobre Ngram, un grupo interno de Google iderado por Jeremy Ginsberg (ver Jeremy Ginsberg et al., «Detecting Influenza Epidemics Using Search Engine Query Data,» Nature 457 (2009): 1012-14), descubrió que las personas están mucho mas predispuestas a buscar síntomas de influenza, complicaciones y remedios durante una epidemia. Esta trivialidad deja de serlo si se puede diseñar una herramienta capaz de detectar las espidemias por región, estado o localidad, a partir de las búsquedas en tiempo real y se logra identificar (como ocurrió) brotes emergentes de enfermedades contagiosas.

Por su parte Raj Chetty (ver Raj Chetty, John N. Friedman, and Jonah E. Rockoff, «The Long-Term Impacts of Teachers,» National Bureau of Economic Research (December 2011); Raj Chetty et al., «How Does Your Kindergarten Classroom Affect Your Earnings?,» National Bureau of Economic Research (March 2011), un economista de Harvard convenció al Internal Revenue Service de UA (la AFIP yanqui), para que compartiera información acerca de millones de estudiantes que habían asistido a clase en distintos distritos.

Sus colaboradores combinaron esta información con una segunda base de datos que registraba trabajos asignados en clases. Mediante esta correlación fue posible saber qué estudiantes habían estudiado con cuáles docentes. De este modo se logró relevar cual es el impacto efectivo de tener un buen docente, así como el impacto (casi siempre trivial o nulo) de las políticas educativas, cuando no s etrabaja con Big Data como en estos casos. Con números en la galera demostraron el impacto que un buen docente tiene en el diseño de las carreras universitarias, en la mejora del ingreso a largo plazo y en la posibilidad de que un alumno termine viviendo en mejores barrios. Con toda esa data en el bolsillo el equipo ayudó a mejorar la medida de la eficacia docente y Chetty ganó a su vez en el año 2013 la medalla John Bates Clar .

Por último (y algo de esto veíamos 10 años atrás en el uso de mercados predictivos en James Surowiecki The wisdom of the crowds) un ex-analista de baseball llamado Nate Silver (Nate Silver, FiveThirtyEight, Nate Silver, The Signal and the Noise. The Art and Science of Prediction (New York: Penguin, 2012), se dedicó a buscar una conexión entre Big Data y los ganadores de las elecciones presidenciales en USA. Usando datos recolectados por Gallup, Rasmussen, RAND, Mellman, CNN, y otras fuentes, Silver anticipó la victoria de Obama en su primer presidencia así como la de 49 colegios electores a excepción del de Indiana. Algo que corrigió en la segunda elección, donde además predijo que Obama tenía un 90.9% de chances de ganarle a Romney

Mas alla del tufillo predictivista que hay en la elección de estos ejemplos de pioneros por parte de Michel y Aiden queda claro que se abre un panorama majestuoso de investigaciones y análisis invisibles hasta hace 5 o 10 años atrás, y que una inteligente combinación de heurística maquinal con interpretación (puntual) humana, permite imaginar unas ciencias sociales (y también naturales) muy diferentes a las que supimos conocer.

Ello también implica revisar de cabo a rabo el curriculum universitario, articular estas herramientas con muchas otros enfoques y actitudes propias de la cultura maker y de las perspectivas de diseño las que estamos involucrados en los últimos años, especialmente desde el lanzamiento de Laboratorios de Arte/Ciencia que iniciamos en el 2012 con ConectarLab y que estamos continuando hoy con el TadeoLab en Bogotá, y en otros lugares en el 2014. Allá vamos

Comentarios