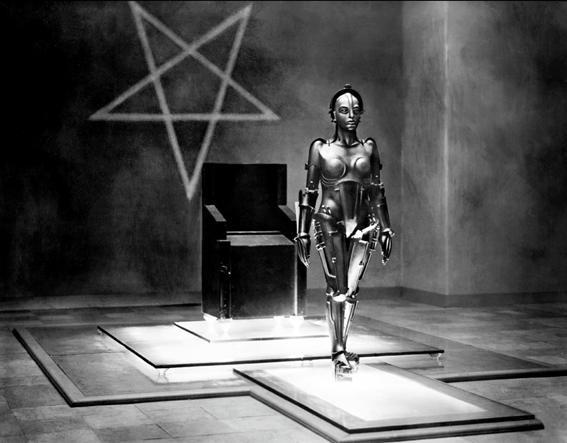

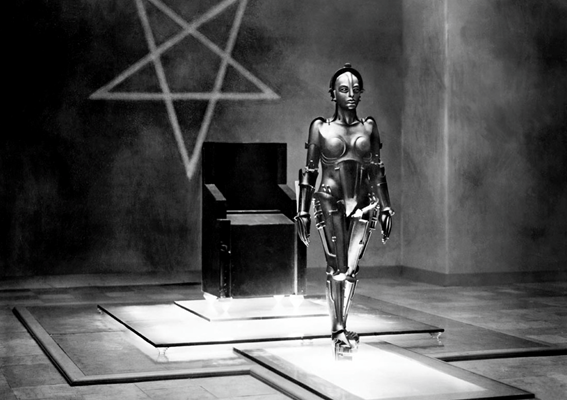

Alan Turing se asoma a nuestras pantallas. Su famoso test, se manifiesta de diversas maneras. Conceptos como el de algoritmo o programa que hoy día nos parecen tan claros, no lo estaban cuando Alan empezó a plantearse dos cuestiones que dieron como resultado sus contribuciones más conocidas: La Máquina de Turing y el Test de Turing. Las mismas pueden considerarse hitos fundacionales de la Ingeniería Informática. El primero define el carácter algorítimico de ‘computación’, mientras que el segundo precisa de manera sistemática un método para acopiar evidencia de vida mental inteligente en computadores programados.

La potencia de la inteligencia artificial (IA) fundamentalmente intenta simular en sistemas informáticos el repertorio de actividades cognitivas complejas que caracterizan a los seres humanos, y así confirmar o no las teorías de cómo funciona la mente. Casi desde su inicio, en la década del 50, este original campo del saber humano se escindió en dos paradigmas: el enfoque simbólico, también llamado IA clásica, y el enfoque subsimbólico, también llamado conexionista. Actualmente es difícil que las máquinas inteligentes se basen en una sola perspectiva.

Para la vertiente simbólica, que dominó el panorama durante las décadas del 60 al 80, la mente es una máquina de procesamiento de información, en donde no interesan los mecanismos biológicos subyacentes. Su estrategia recibe el nombre de «enfoque descendente o Top-Down»: a través de un exhaustivo y pormenorizado conjunto de reglas pre-programadas, se espera que el sistema sea capaz de desenvolverse en el mundo real haciendo hincapié en los aspectos más cognitivos del ser humano, como la lógica, las habilidades deductivas, la capacidad de procesamiento, el razonamiento, la manipulación de símbolos mentales y la combinación de conceptos. La corriente conexionista, intenta imitar el sustrato emergente de la inteligencia, no recreando en detalle los mecanismos biológicos, sino reproduciendo sólo sus propiedades observables. Su estrategia recibe el nombre de «enfoque ascendente o Bottom-Up»: dejan que el sistema se desarrolle a partir de su propia experiencia -al igual que lo hacen los organismos biológicos- haciendo hincapié en los aspectos más perceptivos del ser humano, como el aprendizaje, las habilidades asociativas, las capacidades sensoriales, la generalización, la autonomía y el reconocimiento de patrones.

Desde el comienzo, las exploraciones de Turing enmarcaron la noción de inteligencia relacionada con la capacidad de razonamiento matemático y el manejo de la lógica abstracta. Aparentemente la inteligencia humana no se basa en las reglas de la lógica sino en lo que se denomina «sentido común», o sea la elevada riqueza de conocimientos y la comprensión inmediata del mundo que le rodea y en el que se desenvuelve. Muchos supuestos tácitos en la comunicación (ya sea oral o escrita) se sobreentienden gracias a milenios de evolución bioquímica y cultural como el desenvolverse en nuestro implacable cotidiano. Para que una computadora «piense» de la forma en que lo hace un ser humano, es fundamental que maneje ese conocimiento implícito, tácito, subyacente y previo. En otras palabras, para comportarse adecuadamente en el mundo real y para relacionarse inteligentemente con los seres humanos, la máquina tendría que saber todas las cosas de sentido común -así como la inmensa cantidad de trivialidades- que saben las personas. Claro que sólo una muy pequeña fracción del pensamiento humano es consciente; la mayor parte es, en realidad, pensamiento inconsciente, incluyendo el sentido común.

Para afrontar el problema del conocimiento de sentido común también se podrían utilizar las dos estrategias anteriormente mencionadas. Una de ellas (la simbólica) consiste en representar en la máquina toda la información que posee un ser humano -incluyendo la implícita-, a través de inmensas cantidades de reglas y aprovechando su gran capacidad de análisis, así como su rapidez. El otro camino (el conexionista) reside en construir un sistema que aprenda el conocimiento de sentido común mediante la interacción con las personas.

Independientemente de la estrategia utilizada para lograr el objetivo, el contar con conocimiento de sentido común, permitirá a las máquinas comprender el contexto y, de esa manera, mejorar su desempeño en una gran cantidad de actividades «inteligentes» como tratamiento de lenguajes naturales (tanto oral como escrito), traducciones desde y hacia otros idiomas, reconocimiento de imágenes y de patrones, resolución de problemas o toma de decisiones expertas.

Ambos paradigmas, consideran a la inteligencia como la capacidad de resolver problemas, el necesario diseño de entradas y salidas como el concepto de información.

A continuación una síntesis de ambas perspectivas:

| Programa Sintético | Programa Conexionista | |

| Conocer | Manipulación de símbolos según reglas | Emergencia de estados globales a partir de interacciones simples (locales) |

| Cómo funciona el proceso de conocimiento | Dispositivos capaces de manipular símbolos | Reglas locales que gobiernan operaciones individuales |

| Funciona bien | Símbolos representan la realidad | Propiedades emergentes se corresponden con una aptitud cognitiva determinada |

| Funcionamiento | Mediante lógica y programación. Determinación de funciones lógicas | Aprendizaje: se extiende a lo largo de la generación de la red. Evolución |

| Metáfora | Cerebro como máquina. Los comportamientos producidos son inteligentes | Cerebro viviente. Red |

| Estructura | División entre el Hard y el Soft | Estructura es el Hard y el Soft |

| Proceso de Decisión | Arboles decisorios | Inteligencia reside en el conjunto |

| Computadora | Sistema para manipular símbolos mentales. Representación formal del mundo | Modeliza el cerebro. Simula interacciones entre las neuronas |

| Paradigma de inteligencia | Resolución de Problemas Dispositivo que desarrolla una conducta específica Estructura formal que permite resolver problemas | Heurístico Axiomatización: Red de neuronas. Aprende a discriminar patrones |

| Áreas de trabajo | Resolución de problemas Razonamiento lógico Programación automática | Redes multicapa |

Ambos paradigmas se enfrentan a la misma imposibilidad. Ningún sistema informático puede “observar” el mundo y descubrir proposiciones “verdaderas”. Sabemos que estos criterios son constructos sociales. Al decir de Maturana, somos nosotros mismos la misma prueba viviente de que la evolución es capaz de crear inteligencia a partir de nada, o casi nada. El cerebro humano es el producto final de la experiencia acumulada durante mil millones de años de adaptaciones evolutivas sucesivas ante ambientes dinámicos, a fin de sobrevivir en ellos.

Podrían las máquinas llegar a ser inteligentes? Lo ignoro, pero si la respuesta es afirmativa, la evolución es la manera más segura de alcanzar esa nueva cumbre.

Comentarios